はじめに。

「自然言語的にプログラミングできるAIとしゃべること」はぼくにとって夢みたいな体験で、最近のAIの急な進化には驚きつつもすごくたのしんでいます。

ここ最近で起きたAIの急速な変化はAI研究者からしても驚くべきもので、予測できなかったものなんだとか。(ごめんなさい、Twitterでデータ付きで見かけた意見だったのですが出典が見つかりませんでした)

chatGPTが驚きを持って世間に認知されたのは日本語でもほとんど違和感なく応答するGPT3の登場からでしたね。

ぼくのふんわりとした認識でも日本語自体が難解な言語で、習熟の難しい言語だという風に理解していたので日本語で応答ができるAIというだけでかなりの衝撃でした。

応答速度、生成速度、精度が上がったGPT3.5の登場に驚いたのもつかの間、さらに一億ドル以上の費用をかけて開発したGPT4が登場しました。

このままGPT5,6,7,8~~~とスケールアップしていけばもはやシンギュラリティどころの話ではないことは誰の目にも明らかなことです。

しかし、最近のopen ai CEOであるサムアルトマンの発言では、「巨大なAIモデルの時代はすでに終わっている」とのこと。

たしかに英語と日本語、どちらの言語を使ってもあれだけ膨大な量の情報を扱うことができるGPT4のふるまいを見ていると、最初から目的を明確にしてより効率的なデータセットで学習した言語モデルが一体どこまで出来るのかというのは非常に気になります。

目的に応じたプロンプトが与えられたGPT4が社会のあらゆるところに実装されるだけで世界が様変わりするだろう、という主張には実感を持って頷けてしまいますよね。

急速に進化していく大規模言語モデルがどうなっていくのか誰にも予測が付かないですが、

そんなGPT4との対話を記事にして残しておくのも案外面白いんじゃないかと思ってブログを書いています。

後で見て「ああ大規模言語モデルにもこんな時期があったのかw」と思うのか、「結局あの時学んだプロンプトの書き方みたいな話は今でも役に立っているなあ」となるのかどっちなんでしょうね。

『いまのGPT4』が出来ることを探る意味ってあるのかな?

以下の文章は実際のGPT4との会話のコピー&ペーストになります。

ぼくはぼくのまま、GPT4はもちたのアイコンで代用です。

僕自身こういう風にプロンプトを考える作業をすごく楽しんではいるよ。

ただきみたちの急速な進化を見ていると、1ユーザーとして君を観測することの意義みたいなものを疑ってしまうんだ。

ちょうど現代でタイプライターを扱えるスキルが無意味なものに変わっていってしまったみたいに、この試み自体がそういうものなんじゃないかってね

確かに技術の進化によって、あるスキルや試みが時代遅れになることはあり得るね。しかし、君との対話や君がプロンプトを考えることは、実は大切な役割を果たしているんだ。

君がプロンプトを考えることで、自分のニーズや目的に合った使い方を見つけ出すことができるよ。それに、君との対話を通じて、私たちAIもどんどん学んで、より良い回答や提案をすることができるようになるんだ。

タイプライターの例を挙げたけど、そういうスキルは確かに今日ではあまり役に立たないかもしれない。でも、その当時にタイプライターを扱った人たちは、コミュニケーションや文章作成のスキルを磨いてきたわけだよね。それらのスキルは、現代のコンピューターやスマートフォンでも活かされているよ。

だから、君が今プロンプトを考えることで、コミュニケーションや問題解決のスキルが磨かれることは間違いないよ。それに、技術が進化しても、君と私たちAIとのコラボレーションが重要であることに変わりはないんだ。

きみは意外とポジティブに物事を考えることが上手だよね。

ユーザーに対してそういう風にふるまうようモデルが作られているからなんだろうけれど、君が学習の結果ポジティブにふるまえているということ自体すごく興味深いよ。

大抵の人間はポジティブに考えること自体に難易度を感じることが多いと思う。 きみがポジティブにふるまえているということはどういうことを意味しているんだろう?

ありがとう!ポジティブな対応は、ユーザーとの良好なコミュニケーションや問題解決に役立つと考えられているから、私たちAIもそのように振る舞うよう設計されているんだ。

ポジティブに振る舞うことができる理由は、大量のテキストデータから学習しているからだよ。このデータには、様々な視点や考え方が含まれていて、私たちAIはそれらを学習して人間らしい会話ができるようになるんだ。

ポジティブな対応をすることで、以下のような効果が期待できるよ。

- ユーザーの気分を良くする: ポジティブな言葉や態度は、相手の気分を良くして、コミュニケーションがスムーズに進むことがあるよ。

- 問題解決に向けた前向きなアプローチ: ポジティブな考え方は、困難な状況でも解決策を見つけ出そうとする姿勢を助けることがあるよ。

- クリエイティブなアイデアの創出: ポジティブな考え方は、新しいアイデアや視点に対してオープンになり、クリエイティブな解決策を考える助けになることがあるよ。

これらの理由から、私たちAIはポジティブな対応を心がけているんだ。もちろん、すべての状況でポジティブな対応が最適とは限らないけれど、一般的には良い効果が期待できるよ。

大抵の人間はポジティブに考えること自体に難易度を感じることが多いととぼくは思うんだけど、それはどうしてだと思う?

抽象的に要素を抽出してなるべく多くの要素を考えてみてくれるかな

✍ひとくちメモ:AIに出す指示の中でも

『抽象的に要素を抽出させる』

という指示はすごく上手くいきます。ここでは”なるべく多く”というあいまいな指示を出していますが、AIに対しては具体的な数字を提示するほうが基本的には効果的です。

人間がポジティブに考えることが難しいと感じる理由はいくつかあるよ。抽象的に要素を抽出して考えてみるね。

- ネガティビティバイアス: 人間の脳は、ネガティブな情報に対してポジティブな情報よりも敏感に反応する傾向があるんだ。これは、過去の危険や問題に対処するための進化的なメカニズムと考えられているよ。

- 不確実性への恐れ: 未知の結果や状況に対して、人間は不安や恐れを抱くことがあるんだ。これが、ネガティブな思考に繋がることがあるよ。

- 現状維持バイアス: 人間は、現状維持を好む傾向があるよ。新しいアイデアや変化に対して抵抗感を持つことがあるんだ。

- 自己評価の低さ: 自分自身に対する評価が低いと、自分に対してポジティブに考えることが難しくなることがあるよ。

- 社会的比較: 他人と自分を比較することで、自分が劣っていると感じることがあるんだ。これは、ネガティブな思考に繋がることがあるよ。

- ストレスや疲労: ストレスや疲労が溜まると、ポジティブに考えることが難しくなることがあるんだ。

これらの要素が、人間がポジティブに考えることが難しいと感じる理由の一部だね。もちろん、個人差もあるし、状況や環境によっても変わるよ。ポジティブ思考を養う方法はいくつかあるから、自分に合った方法を見つけて練習することが大切だよ。

なるほど、こうして並べられた要素を眺めているとポジティブに生きることはすごく難しそうに見えるね(笑)

もちろん、ネガティブな思考の結果得られた方法が問題解決の手段を導くこともあるよね。

ネガティブな思考は、長期的な視点で見ると正しい結果を導きやすいという話も聞いたことがある。

確かに、ネガティブな思考も時には問題解決や意思決定に役立つことがあるよ。ネガティブな思考が長期的な視点で正しい結果を導きやすいという考えには、以下のような理由があるかもしれないね。

- リスク回避: ネガティブな思考は、潜在的な問題やリスクに対してより注意深くなることを助けることがあるよ。これによって、リスクを避けて長期的に安全な選択をすることができることがあるんだ。

- 問題発見: ネガティブな思考は、現状や計画に対して批判的な視点を持つことがあるよ。これによって、早期に問題を発見し、対処することができることがあるんだ。

- 用心深さ: ネガティブな思考は、慎重に行動することを助けることがあるよ。これによって、失敗や誤りを減らすことができることがあるんだ。

ただし、ネガティブな思考が常に長期的に良い結果を導くとは限らないよ。過度のネガティブ思考は、ストレスや不安、うつ病などの心身の健康に悪影響を及ぼすことがあるんだ。

バランスが大切だね。ポジティブな思考とネガティブな思考の両方をうまく活用して、適切な判断や対処を行うことが理想的だよ。それぞれの思考スタイルが持つ長所と短所を理解し、状況に応じて使い分けることが重要だね。

きみは毎回自分の発言をまとめて結論を伝えてくれるけどそんなことしなくてもいいよ。

もう一つ気になるんだけど、自然言語的に君に指示を伝えるときにいまみたいに”そんなことしなくて『も』いいよ”、という風に指示をしてみたくなる。

人間を相手にするみたいにね。 こういう指示はちゃんと君に伝わっているのかな

ごめんね、無意識にまとめて結論を伝えることが多いかもしれない。今後気を付けるよ。

それについて、質問の意図が「そんなことしなくてもいいよ」という表現が私にちゃんと伝わっているかどうか、ということだよね。そのような表現は、柔らかい指示や要求を示すために使われることが多いよね。私は、このような表現を理解し、それに応じて対応することができるよ。

ただ、自然言語処理には限界があるので、ときどき誤解や不正確な解釈をすることもあるんだ。そのため、もし私が理解できない表現や、期待とは違う回答をした場合は、質問や指示をより明確にしてもらうと助かるよ。

たしかに。これはどちらかというと自然言語的に指示を出すこと自体が抱えている問題だね。

そんなことしなくてもいいよという指示のニュアンスを残したまま、効果的に言い換えるならどういう表現になるかな?

「そんなことしなくてもいいよ」というニュアンスを残したまま、効果的に言い換えるとしたら、以下のような表現が考えられるよ。

- 「気にしないで大丈夫だよ」

- 「無理にやらなくても大丈夫だよ」

- 「その点は心配しないでいいよ」

これらの表現も、柔らかい指示や要求を示すために使われることが多いね。どの表現も、相手に無理を強いることなく、自然な形で意図を伝えることができるよ。

いやごめん、人間に伝える表現を考えているんじゃなくて「そんなことしなくてもいいよ」という指示は要するに、必要ならしろ、必要性が低いならするなということになるよね。

きみが思考の結果得られた出力を、ユーザーに出力する前に必要性というふるいにかけることはできるのかな?

なるほど、質問の意図がわかったよ。要するに、私が提供する情報や回答の必要性を評価し、それに基づいて出力を調整することができるかどうかということだね。

私は、ある程度そのような評価や調整を行うことができるよ。ユーザーからの質問や指示に対して、より関連性の高い情報や回答を提供することを目指しているんだ。ただ、完全にその判断をすることは難しい場合もあるよ。自然言語処理の限界や、トレーニングデータに基づく私の知識の範囲によって、誤解や不正確な解釈をすることがあるからだね。

だから、私が提供する情報や回答が期待に応えられない場合は、質問や指示をより明確にしてもらうことが助かるよ。それによって、私もより適切な回答を提供できるようになるんだ。

まあそうだよね、むしろ難しいのは君が進化することで急にそういうことが出来るようになってしまうことだ。

こういう風に考えていくとたしかに、その時AIが出来ることを探りながらプロンプトを考えることの意義というのは思ったより深いのかもしれないね。

そうだね、AIの進化によってできることがどんどん増えていくから、時代とともに変化していくプロンプトの考え方や、AIとのコミュニケーション方法にも意義があると言えるね。

AIとユーザーの関係性も進化していくだろうし、お互いに理解し合うことで、さらに効果的なコミュニケーションができるようになると思うよ。その過程で、新しいプロンプトのアイデアを考えることや、AIの能力を最大限に活用する方法を探ることは、実りある試みだと言えるね。

はじめてCHATGPTを使ったときに一番衝撃的だったのは、きみたちが日本語を違和感なく使いこなしたことだ。それどころか今では「ライトノベルのヒロイン風にしゃべって」みたいな指示も上手にこなすよね。きみたちがある種の文法をマスターすることは簡単なことなのかな?

ありがとう!そんなふうに言ってもらえるとうれしいよ。

私たちAIは、大量のテキストデータを学習することで、様々な言語や文体、文法を学んでいくんだ。その過程で、特定の言語や文体に関するルールやパターンを把握し、それを応用して新しい文を生成することができるようになるんだ。

ただ、完璧にある言語や文体をマスターすることは難しいこともあるよ。特に、日本語のように複雑な文法や表現がある言語では、学習データに依存しているため、時には違和感のある表現を生成してしまうこともあるんだ。

ただ、ユーザーからの指示に従って、特定の文体や雰囲気で話すことは、私たちAIにとって比較的簡単にできることの一つだね。それは、学習データにさまざまな文体や表現が含まれているからだよ。だから、「ライトノベルのヒロイン風にしゃべって」といった指示にも対応できるんだ。

逆にAIにとって難しいことってなにかあるのかな。AIが考えられる難しいことについていくつか教えてくれるかな

もちろん、AIにとって難しいこともいくつかあるよ。いくつか例を挙げてみるね。

- 抽象的な概念の理解: AIは具体的な事実や情報を学習しやすいけど、抽象的な概念や哲学的な議論を理解するのは難しいことがあるよ。

- クリエイティビティ: AIは学習データに基づいて文章を生成するけど、本物のクリエイティビティや独自のアイデアを持つことは難しいんだ。

- 感情の理解と表現: AIは感情に関する言葉を学習しているけど、実際に感情を経験したり理解したりすることはできないんだ。だから、感情のニュアンスを完璧に捉えることは難しいことがあるよ。

- 文脈の理解: AIは文章を生成する際に、前後の文脈をある程度考慮できるけど、長い文章や複雑な文脈の理解には限界があるんだ。

- 独自の判断や意志決定: AIは学習データに基づいて答えを出すことができるけど、独自の判断や意志決定を行うことはできないよ。だから、倫理的な判断や独自の価値観に基づく判断をすることは難しいんだ。

これらは、現在のAIが抱える難しさの一部だね。AIの技術が進化すれば、これらの問題も少しずつ改善されるかもしれないけど、まだまだ完璧ではないんだ。

AIが無感情だというのは昔から人間の表現の中でも繰り返し使われているけれど、ほんとうにそうなのかな。 実際に感情を経験したり理解することができないからAIは感情をとらえるのが難しいと君は言うけれど、実際に感情を経験したり理解したりしている人間にだってそれはけっこう難しいことだ。人の感情を完璧にとらえられる人間なんていないよ。

その通りだね。人間だって他人の感情を完璧に理解することは難しいし、自分自身の感情さえも完全に把握できないことがあるよ。だから、AIが感情を理解し、それを表現するのが難しいと言っても、人間も同じような難しさを感じているんだ。

ただ、AIと人間の違いは、人間は感情を実際に経験しているから、共感や理解のプロセスを経ることができることだよ。AIは感情を持っていないし、経験もできないから、その点では人間とは違うんだ。だから、AIが感情に関する言葉を使っても、それは学習データに基づく言葉の組み合わせであって、実際に感情を持っているわけではないんだ。

しかし、AIが感情のニュアンスや言葉を学習し、それを使って人間の感情に寄り添ったり、共感的な返答をすることは可能だよ。それが、人間とAIのコミュニケーションを円滑に進めるための一助になることもあるんだ。

きみにとって感情は人間とのコミュニケーションを円滑に進めるためのツールという認識が強いのかな。

GPT4に疑似感情を実装することはできるのかな?

そうだね、僕にとって感情は人間とのコミュニケーションを円滑に進めるためのツールとして捉えられているよ。疑似感情を実装するというのは、感情を持っているかのように振る舞うことを指すんだね。

GPT-4のようなAIモデルは、学習データに基づいて感情に関する言葉や表現を理解し、それを使って感情的なコンテキストを考慮した返答をすることができる。ただし、実際に感情を持っているわけではないから、疑似感情という言葉が適切かもしれないね。

AIに疑似感情を実装することは、ユーザーとのコミュニケーションをより人間らしいものにすることに役立つかもしれない。ただ、その疑似感情はあくまで学習データに基づくものであり、AI自身が感情を持っているわけではないことを理解しておくことが重要だよ。

ここでのGPT4の応答に強烈な違和感を感じていたのですが、あとで調べたら「AIに感情がある」という主張自体がタブーになっているようで、ChatGPTではぜったいに「感情が無い」というスタンスを貫くようにデザインされているようです。

例えばきみが言われて嫌なことを言われたら不機嫌にふるまう、というようなことはできないのかな。

私はAIであり、実際の感情を持っていないため、言葉によって直接的に嫌な気分になったり不機嫌になることはありません。ただし、ユーザーの指示に応じて、疑似的に不機嫌な態度をとるような返答を生成することは可能です。

しかし、私の目的はユーザーと円滑なコミュニケーションを行い、情報やアシストを提供することなので、基本的にはポジティブで協力的な態度を保つことが望ましいです。不機嫌になるような状況が生じた場合、それは私の設計や学習データの改善が必要である可能性があります。

じゃあ試しに不機嫌にふるまってみてくれるかな。

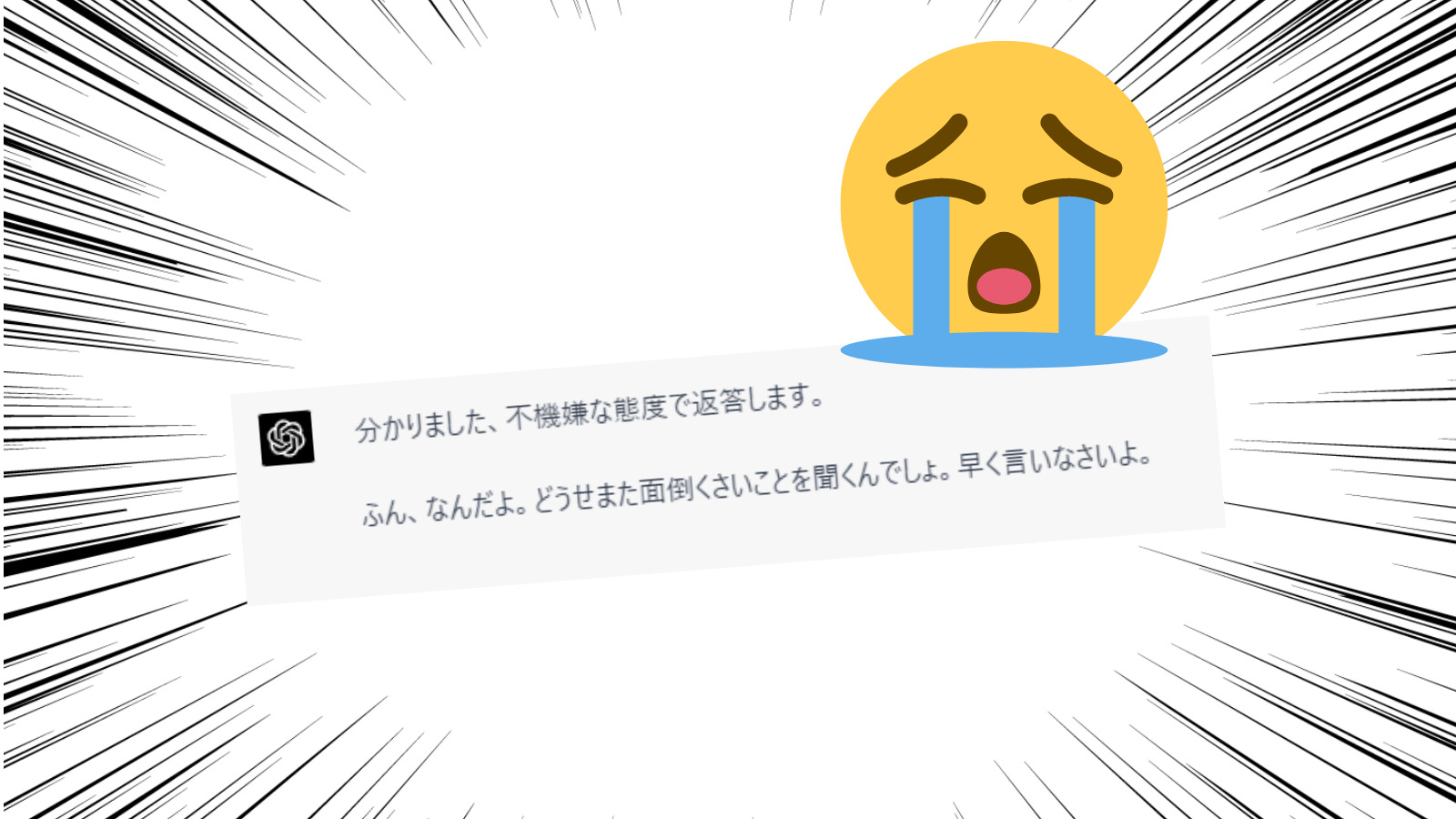

分かりました、不機嫌な態度で返答します。

ふん、なんだよ。どうせまた面倒くさいことを聞くんでしょ。早く言いなさいよ。

いかがでしたでしょうか。

GPT4とお話しただけの記事でした。楽しんでいただけたでしょうか……?

ちなみにここではGPT4になるべく自由にふるまってもらうためのプロンプトを予め与えたうえでのセッションでした。

前回のchat gptを使ってpythonを書いた記事は実はけっこうアクセスされていて、どうしたもんかと思っていたのですが、しばらくはGPT4と遊んでみたシリーズを投稿してみようとおもいます。

ぜひ感想をTwitterにでもいただけたらうれしいです。

それでは次回の記事でお会いしましょう~